I computer quantistici, grazie alle loro capacità di elaborare simultaneamente molte informazioni, sono destinati a rivoluzionare il mondo della ricerca. E sono una delle tecnologie più promettenti per il futuro l’astrofisica. L’Inaf sta lavorando proprio per comprendere come fruttarla al meglio.

Il calcolo quantistico rappresenta una rivoluzione rispetto al calcolo classico. Si basa su principi fondamentalmente diversi e, quindi, rappresenta un differente paradigma che sta aprendo nuove prospettive in vari campi della scienza, inclusa l’astrofisica. Questo cambio di paradigma sta portando molti esperti a parlare di una seconda rivoluzione quantistica, successiva a quella degli inizi del Novecento e che nei prossimi decenni potrebbe portare a innovazioni radicali in molti campi della scienza e dell’industria. La prima rivoluzione quantistica, iniziata appunto agli albori del Novecento con i lavori di scienziati come Max Planck e Niels Bohr, ha portato alla formulazione della meccanica quantistica, una teoria che descrive il comportamento di particelle subatomiche, e ha creato i presupposti per la realizzazione di molte tecnologie moderne, tra cui possiamo ricordare i transistor, alla base di tutti i dispositivi elettronici odierni, e il laser. La seconda rivoluzione quantistica, in cui ci troviamo ora, è caratterizzata dall’applicazione diretta delle leggi quantistiche alla manipolazione e all’elaborazione delle informazioni, concentrandosi sulla capacità di controllare e utilizzare le proprietà quantistiche in modo mirato per creare nuovi paradigmi tecnologici. La seconda rivoluzione riguarda lo sviluppo del quantum computing, della comunicazione quantistica e della metrologia e sensoristica quantistica. Questa epoca è caratterizzata da una fase di sperimentazione avanzata e di innovazione. Anche se i computer quantistici sono ormai una realtà, non abbiamo ancora computer quantistici stabili, potenti e di facile accesso. Per questo motivo la maggior parte delle attività di sviluppo sono svolte su simulatori.

LE ORIGINI

L’idea del computer quantistico fu proposta per la prima volta da Richard Feynman nel 1982. Feynman sottolineò che la natura, governata da leggi quantistiche, non può essere pienamente descritta da un computer classico. Infatti, solo un computer che opera secondo le leggi della meccanica quantistica potrebbe modellare la complessità della realtà microscopica in modo adeguato. Il concetto fu rivoluzionario: Feynman indicò chiaramente che i computer quantistici non sarebbero stati una versione migliorata dei computer classici ma una tecnologia completamente diversa, con un approccio radicalmente nuovo alla risoluzione di problemi complessi.

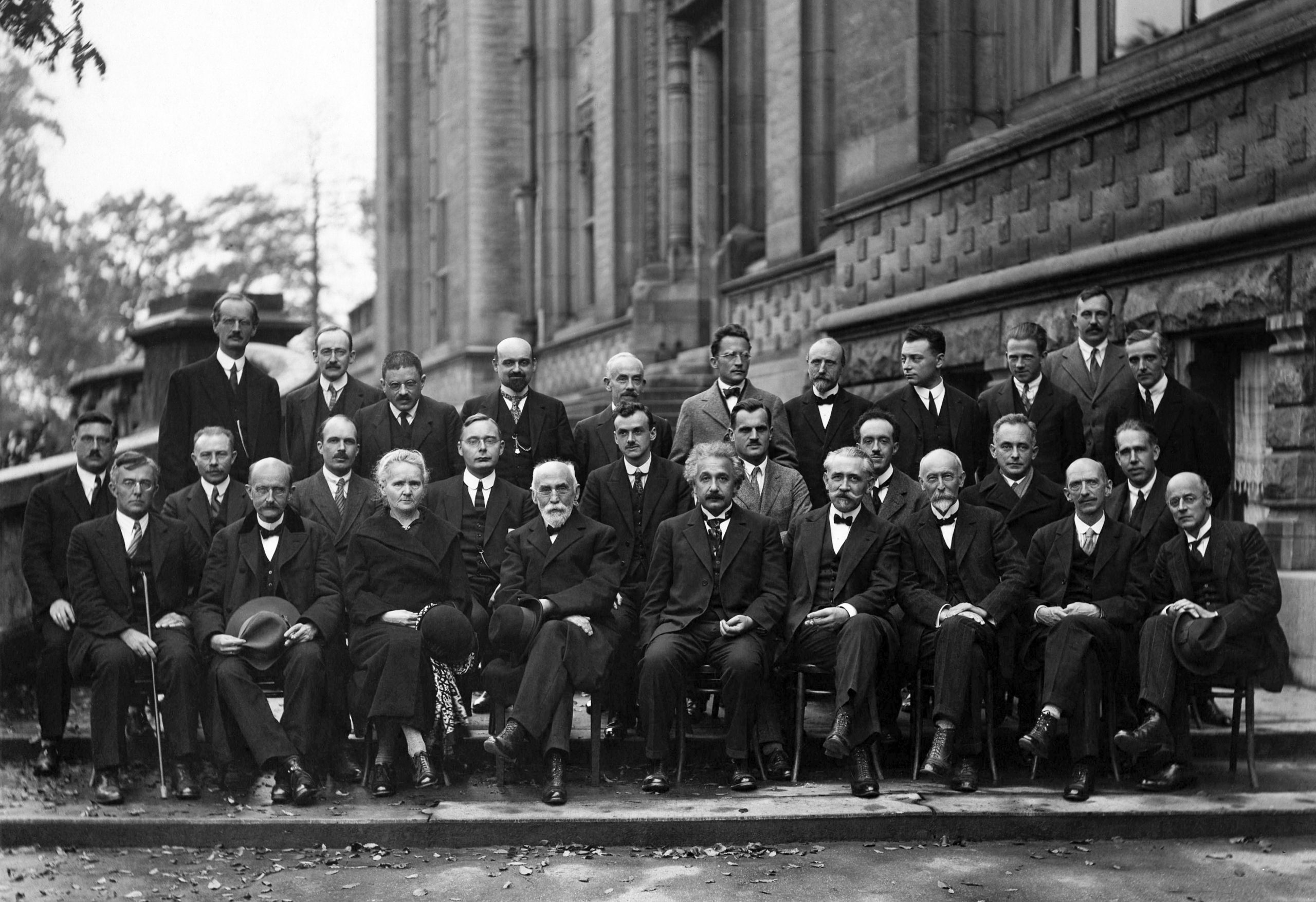

Schrödinger, de Broglie, Heisenberg, Rutherford (e tanti altri) alle Conferenze di Solvay, 1913. Crediti: Institut International de Physique Solvay

Alla base dei computer quantistici

Due concetti chiave della fisica quantistica, la sovrapposizione e l’entanglement, sono alla base del funzionamento dei computer quantistici.

La sovrapposizione è una proprietà fondamentale della meccanica quantistica, secondo la quale una particella elementare può esistere contemporaneamente in più stati, fino a quando non viene osservata o misurata; quando viene effettuata una misurazione la particella assume un unico stato specifico. Prima di tale misurazione, però, la particella si trova in una combinazione di tutti i suoi stati possibili.

La sovrapposizione ha implicazioni cruciali nel quantum computing. Nei computer classici, infatti, elaborano un’informazione alla volta, che è codificata in bit che devono essere 0 o 1. In un computer quantistico, invece, si utilizzano i qubit, che in sovrapposizione possono contemporaneamente essere sia 0 sia 1, consentendo così di codificare più informazioni. Questo significa che un computer quantistico può elaborare simultaneamente molteplici combinazioni di informazioni, aumentando esponenzialmente la velocità di calcolo.

L’entanglement, invece, è un fenomeno per il quale due o più particelle diventano interconnesse, e lo stato di una influenza immediatamente quello dell’altra, indipendentemente dalla distanza che le separa. Questo fenomeno consente ai qubit di “collaborare” tra loro, permettendo al computer quantistico di eseguire calcoli complessi in modo parallelo, sfruttando il legame tra i qubit.

Queste due proprietà sono ciò che rendono i computer quantistici fondamentalmente diversi da quelli comuni, e non una loro versione più potente.

L’Inaf, il calcolo quantistico e l’Icsc

Una simulazione di collisione fra gas, filamenti e galassie. Crediti: Tng Collaboration

L’Inaf è coinvolto nello sviluppo di applicazioni avanzate di calcolo quantistico per la ricerca astrofisica nel contesto dell’Icsc, il Centro nazionale di High Performance Computing, Big Data e Quantum Computing inaugurato a Bologna presso il Tecnopolo e parte del Piano nazionale di ripresa e resilienza (Pnrr), finanziato con quasi 320 milioni di euro. Icsc è un’iniziativa strategica italiana volta a creare un’infrastruttura nazionale di supercalcolo e si concentra su aree chiave che richiedono un’enorme capacità di calcolo.

Il Tecnopolo di Bologna ospiterà uno dei nuovi computer quantistici europei, parte dell’iniziativa EuroHPC, che mira a sviluppare un’infrastruttura di calcolo ad alte prestazioni in Europa. Questo computer quantico sarà integrato nel sistema pre-exascale Leonardo, già uno dei supercomputer più potenti al mondo, per creare una piattaforma di calcolo ibrida in cui tecnologie quantistiche e classiche lavoreranno insieme. Gli spoke all’interno dell’Icsc sono nodi specializzati che si concentrano su ambiti specifici. L’Inaf ricopre un ruolo attivo nello spoke 10, dedicato all’applicazione del calcolo quantistico per la ricerca astrofisica e cosmologica. Le attività che l’Inaf sta svolgendo coprono diversi settori.

Applicazioni del Quantum Computing

Il potenziale del quantum computing è vasto e promette di rivoluzionare molti settori. In fisica fondamentale, i computer quantistici potrebbero essere utilizzati per simulare l’evoluzione di sistemi quantistici complessi, come le interazioni tra particelle in un campo quantistico. In ambito biomedico, questi computer potrebbero simulare la struttura di molecole complesse, accelerando la scoperta di nuovi farmaci. Infine, nella crittoanalisi, potrebbero violare i sistemi di crittografia classici, incentivando così lo sviluppo di nuovi protocolli di sicurezza basati sulle leggi quantistiche.

In astrofisica, poi, il quantum computing apre opportunità straordinarie. Eccone riportate alcune a cui si sta lavorando nell’Inaf, ma le applicazioni sono molte di più.

Applicazioni in astrofisica

Uno dei temi centrali è l’applicazione del quantum computing per simulare l’evoluzione dell’universo. Lavoriamo su modelli matematici che descrivono l’evoluzione della materia oscura attraverso equazioni come quelle di Schroedinger-Poisson e Vlasov-Poisson. Queste equazioni permettono di descrivere l’interazione tra le particelle subatomiche e i campi gravitazionali. Grazie al quantum computing, stiamo studiando come risolverle in modo più efficiente e con maggiore precisione rispetto ai metodi classici. È in corso l’estensione a fenomeni idrodinamici.

Un altro campo di ricerca riguarda l’ottimizzazione per la stima dei parametri e la selezione di modelli cosmologici, il cui studio necessita di matrici di covarianza di enormi dimensioni e trovare soluzioni estremali anche tramite l’uso di versioni quantistiche di algoritmi genetici, simulated annealing e Monte Carlo chains. Un esempio di applicazione all’analisi dati algoritmi riguarda la modellizzazione delle lenti gravitazionali forti. Questi fenomeni ci permettono di osservare la distribuzione della materia oscura nell’universo, studiando come la gravità prodotta da oggetti massicci come gli ammassi di galassie distorca il percorso della luce. Grazie agli algoritmi quantistici, possiamo esplorare rapidamente un gran numero di configurazioni per trovare quelle che meglio si adattano ai dati osservativi.

Le nubi di Magellano nell’obiettivo del satellite Esa Planck, che dal 2009 al 2013 ha scandagliato il cielo a caccia della traccia residua del big bang, il Cmb. Crediti: Esa/Planck Collaboration

Inoltre, stiamo esplorando l’uso del Quantum Machine Learning (Qml) per migliorare le tecniche del machine learning classico. Si tratta di una branca dell’intelligenza artificiale che si focalizza sullo sviluppo di algoritmi e modelli statistici che permettono ai computer di apprendere dai dati. Stiamo sviluppando reti neurali quantistiche che apprendono dai dati reali o simulati dei nostri telescopi, per il rilevamento dei Gamma-Ray Burst (Grb), lampi di raggi gamma che provengono da eventi catastrofici nello spazio. Quello che stiamo osservando dalle nostre prime esperienze è che una rete neurale quantistica sembra essere in grado di imparare con molti meno dati di esempio rispetto a una rete classica.

Un altro aspetto che stiamo studiando è la separazione delle componenti del Cosmic Microwave Background (Cmb) per comprendere l’evoluzione dell’universo. Il segnale del Cmb è mescolato con altre fonti di radiazione, ed è necessario separare queste componenti per ottenere una visione chiara del cosmo primordiale. I risultati verranno poi estesi allo studio della parte primordiale dei segnali di rionizzazione, dominata da foregrounds.

Infine, l’uso di tecniche di ottimizzazione come la minimizzazione di funzioni multiparametriche può assumere un’importanza rilevante. La maximum likelihood estimation – una tecnica ampiamente utilizzata per stimare i parametri di un modello statistico massimizzando la probabilità che un insieme di dati osservati provenga da quel modello – può beneficiare notevolmente delle potenzialità del quantum computing.

Le collaborazioni

La Bologna Quantum Alliance (Boqa) è un’organizzazione coordinata dall’ Alma Mater Studiorum – Università di Bologna che include tutti i maggiori centri di ricerca italiani e mira a creare un ecosistema per le tecnologie quantistiche in vari settori. L’ Inaf fa parte di questa organizzazione, nata a luglio 2024, che in futuro ci permetterà di stringere ulteriori collaborazioni con i principali protagonisti nell’ambito dell’Emilia-Romagna, italiano ed europeo.

Collaboriamo con l’Università degli Studi di Napoli Federico II, che è un punto di riferimento in Italia per la ricerca e lo sviluppo nel campo del quantum computing. Ospita il Superconducting Quantum Computing Center, inaugurato a maggio 2024, uno dei primi centri di questo tipo in Italia, specializzato sullo sviluppo di computer quantistici basati su piattaforma a superconduttori.

Tutte queste attività sono volte in stretta collaborazione con la struttura organizzativa Usc VIII dell’Inaf, che si occupa di coordinare le attività di calcolo.

Sfide tecnologiche e prospettive future

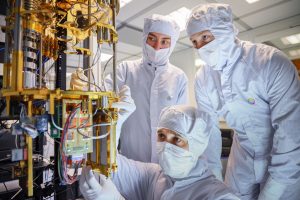

Ricercatori assemblano la parte criogenica di un computer quantistico, perché i processori superconduttori possano lavorare quasi allo zero assoluto (-271,1°C). Crediti: FNMLab

Esistono diversi approcci alla costruzione di computer quantistici, come l’uso di superconduttori, trappole di ioni e atomi freddi, ma nessuno di questi ha ancora raggiunto una maturità sufficiente per l’implementazione su vasta scala. Ogni approccio presenta vantaggi e svantaggi: i superconduttori sono facili da scalare ma richiedono temperature estremamente basse, mentre le trappole di ioni sono molto precise ma difficili da espandere a un numero elevato di qubit.

Attualmente, lo sviluppo dei computer quantistici si trova in una fase definita come rumorosa e intermedia, caratterizzata da prototipi che funzionano, ma non hanno ancora raggiunto la supremazia quantistica, cioè la capacità di risolvere problemi che i computer classici non possono affrontare in tempi ragionevoli. Questa fase è nota come Noisy Intermediate-Scale Quantum (Nisq), in cui i sistemi quantistici esistenti contano su un numero limitato di qubit e sono ancora soggetti a errori significativi a causa di fenomeni come la decoerenza e il rumore quantistico, che rende difficile mantenere stabili i qubit durante i calcoli.

Tuttavia, i progressi sono rapidi. L’hardware quantistico sta migliorando costantemente, gli algoritmi e le applicazioni del quantum computing stanno già affrontando problemi che i metodi classici non potrebbero mai affrontare in tempi ragionevoli.